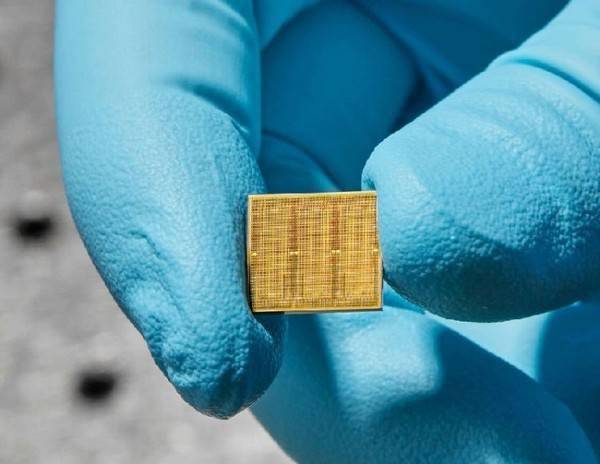

14納米模擬AI芯片

隨著AI技術的廣泛應用,對能源和資源的需求也在不斷增長。特別是在語音識別領域,軟件升級雖然極大提升了自動轉寫的準確率,但由于需要在存儲器與處理器之間移動大量的運算數據,硬件無法跟上訓練和運行這些模型所需的數以百萬計的參數。為了解決這個問題,研究人員提出了一種名為“存內計算”(CiM,或稱模擬AI)的解決方案。

模擬AI系統通過直接在它自己的存儲器內執行運算,避免了在存儲器和處理器之間移動數據的低效。這種技術預計能極大提升AI計算的能效。對此,IBM的研究團隊成功開發了一個14納米的模擬芯片,該芯片包含3500萬個相變化內存單元,能在34個模塊中進行操作。

研究團隊使用兩個語音識別軟件進行了測試,一個是谷歌的小網絡,另一個是Librispeech的大網絡。當應用于更大的Librispeech模型時,該模擬芯片的性能超出了想象,能達到每秒每瓦12.4萬億次運算,系統性能估計最高能達到傳統通用處理器的14倍。

研究團隊總結道,這項研究在小模型和大模型中同時驗證了模擬AI技術的性能和效率,有望成為數字系統的商業可行的替代選擇。這一突破性的發現,不僅為AI技術的發展開辟了新的道路,也可能將提供更高效、更環保的計算方式。